AdamW:解耦合的权重衰减正则化

对于标准随机梯度下降,$L_2$正则化与权重衰退正则化的作用是相同。然而,对于自适应梯度下降算法,例如:Adam,这种等效不存在。确切的说,由于大部分深度学习库中正则化利用的是$L_2$,从而导致部分任务中利用带有动量的SGD进行优化产生的性能优于自适应梯度下降算法优化产生的模型。AdamW梯度下降算法通过对权重衰减与学习率设置进行解耦合,从而提升Adam算法的泛化性。

解权重衰减与基于梯度更新之间的耦合

权重$\theta$的指数级衰减,可描述为

$$

\begin{aligned}

\theta_{t+1}=(1-\lambda)\theta_t-\alpha\nabla f_t(\theta_t)

\end{aligned}\tag{1}

$$

命题1:带有学习率$\alpha$的SGD对损失函数$f_t(\theta)$执行衰减系数为$\lambda$的权重衰减的优化效果与在函数$f_t^{reg}=f_{t}(\theta)+\frac{{\lambda}'}{2}\Vert\theta\Vert_2^2$且${\lambda}'=\frac{\lambda}{\alpha}$的优化效果一致。

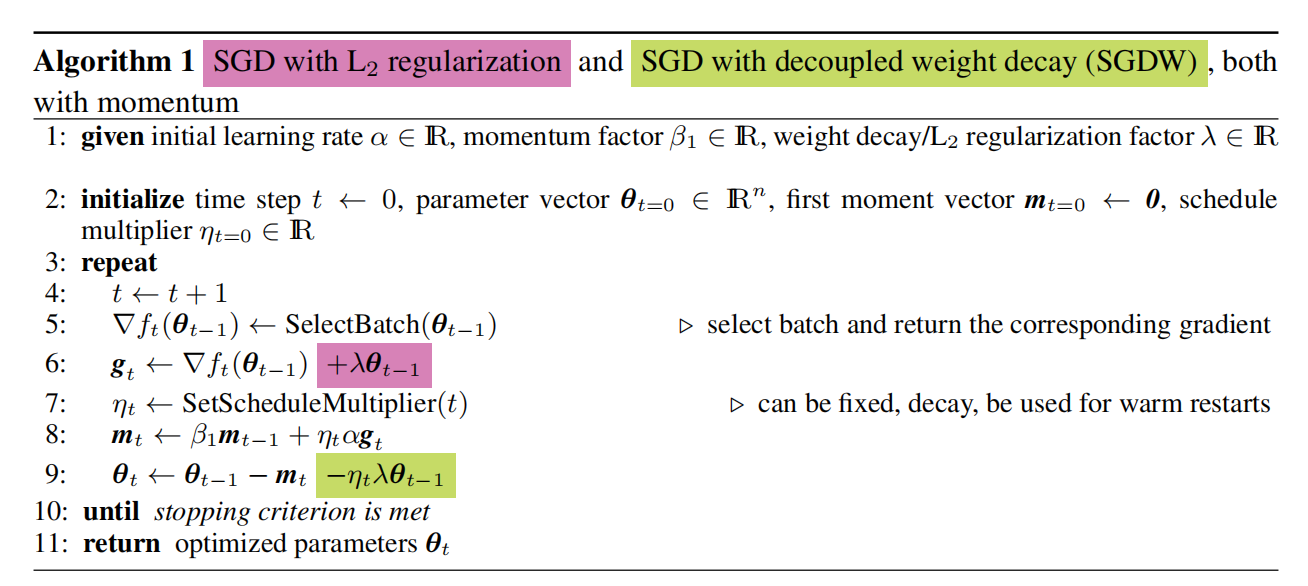

根据命题一,若要这种等价效果保持,需要设置$L_2$的正则化系数${\lambda}'=\frac{\lambda}{\alpha}$,即${\lambda}'$的取值与学习率$\alpha$相耦合。为了解耦合这两个超参数,对式(1)中的权重衰减进行解耦合。如算法1的第9行对权重进行更新的同时衰减权重,由此产生了SGDW。这种简单的改进明确的对$\lambda$与$\alpha$之间进行了解耦合。同时,为了考虑$\alpha$与$\lambda$的调度,因此引入了由$SetScheduleMultiplier(t)$确定的缩放系数$\eta_t$。

对于自适应梯度算法来说,梯度是通过历史梯度信息进行缩放的,例如:Adam。直觉上,若Adam算法对损失函数$f$与$L_2$正则化进行优化,那么$f$中梯度较大的权重往往没有解耦合的权重衰减得到的正则化多。这是因为正则化器的梯度随着损失函数$f$的梯度被缩放了,从而导致$L_2$正则化与自适应梯度算法的解耦合权重衰减的不一致。

命题2:若用$O$表示优化器在无权重衰减的损失函数$f_t(\theta)$上$\theta_{t+1}\leftarrow \theta_t-\alpha M_t\nabla f_{t}(\theta_t)$的迭代与优化器在有权重衰减的损失函数$f_t(\theta)$上$\theta_{t+1}\leftarrow (1-\lambda)\theta_t-\alpha M_t\nabla f_{t}(\theta_t)$的迭代,且$M_t\neq kI$。那么,不存在$L_2$系数${\lambda}'$在无权重衰减的损失函数$f_t^{reg}=f_t(\theta)+\frac{{\lambda}'}{2}\Vert\theta\Vert_2^2$上运行$O$与在权重衰减系数为$\lambda\in R^{+}$的损失函数$f_t(\theta)$上运行$O$等价。

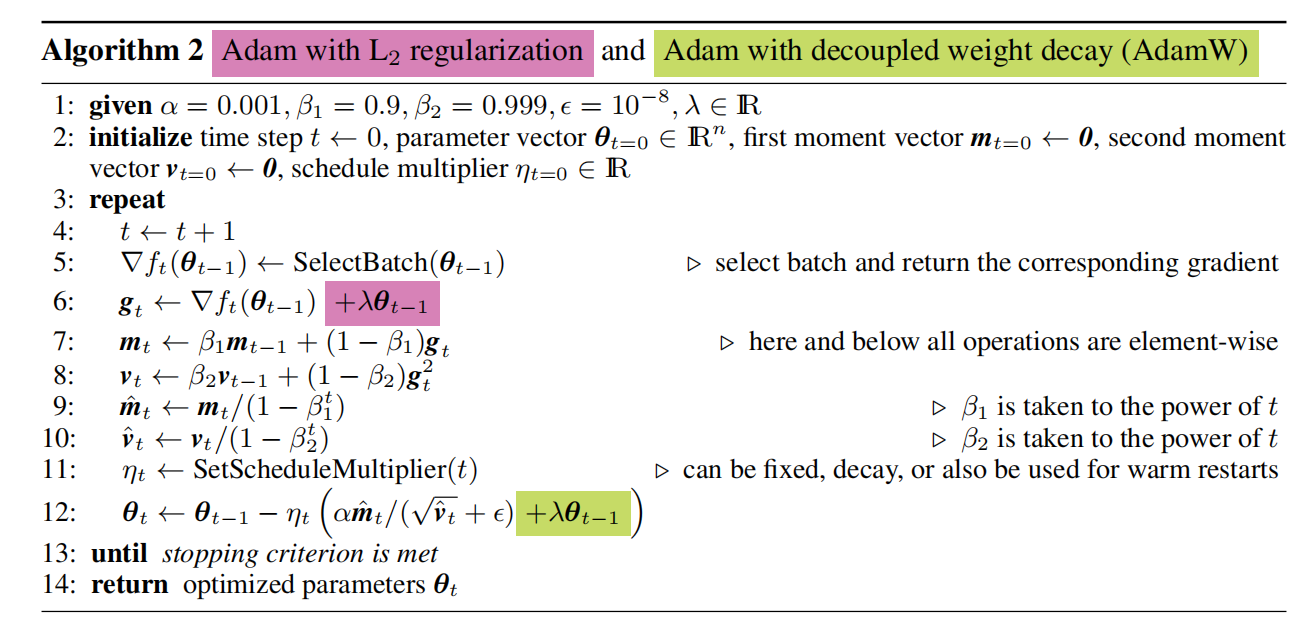

如算法2的第12行所示,对Adam算法中基于损失的梯度更新与权重衰减进行了解耦合,由此形成了AdamW。通俗的说,对自适应梯度优化算法,损失函数的梯度与$L_2$正则化器的梯度同时进行了自适应,从而导致拥有大梯度的权重被正则化的幅度相对小于拥有小梯度的权重。与之不同,AdamW算法的梯度显示的增加了权重衰减,因此进行了有效的梯度正则化。同时,作者们对带有固定预调节器的自适应梯度算法进行了证明

命题3:与命题2一致,利用$O$表示相同的迭代运算,且固定预调节器矩阵$M_t=diag(s)^{-1}$与$s_i\gt0$。那么,学习率为$\alpha$的情况,在带有权重衰减系数$\lambda$的损失函数$f_t(\theta)$上执行$O$与在无权重衰减的损失函数

$$

\begin{aligned}

f_t^{sreg}(\theta)=f_t(\theta)+\frac{{\lambda}'}{2\alpha}\Vert\theta\odot\sqrt{s}\Vert_2^2

\end{aligned}\tag{2}

$$

上执行$O$的效果一致。式(2)中${\lambda}'=\frac{\lambda}{\alpha}$

由于每个步骤中预调节器矩阵均会改变,因此无法直接应用到实际的自适应梯度算法。尽管如此,等价的损失函数表明:参数$\theta_i$的逆预调节器$s_i$值较大,那么权重参正则化效果比基于$L_2$正则化效果大。

值得一提的是,虽然Adam算法学习率是自适应调整的,但不排除利用全局学习率调度器大幅度提升性能的可能性。

引用方法

请参考:

li,wanye. "AdamW:解耦合的权重衰减正则化". wyli'Blog (Apr 2024). https://www.robotech.ink/index.php/archives/397.html

或BibTex方式引用:

@online{eaiStar-397,

title={AdamW:解耦合的权重衰减正则化},

author={li,wanye},

year={2024},

month={Apr},

url="https://www.robotech.ink/index.php/archives/397.html"

}