RL中表示(二):表示的评估与提取方法

在《RL中表示(一):样本效率和模型性能的提升方法》中提到:表示可提高RL的性能和样本效率。在RL训练过程中,表示的提取方式有两种,一种是把无监督损失作为辅助目标;另一种是预训练离线数据,作为Online RL的先验。那么,表示的对下游任务影响的评估方法是什么呢?两种表示提取方法都有哪些方法呢?

表示质量的评估方法

《On the Importance of Feature Decorrelation for Unsupervised Representation Learning in Reinforcement Learning》利用特征秩估计表示对下游RL任务的影响。《Light-weight probing of unsupervised representations for Reinforcement Learning》通过两个任务评估表示质量,分别是:

- 给定状态的表示,基于线形映射预测其奖励。

- 给定状态的表示,预测特定策略(例如:专家策略)的动作。

表示提取的方法

预训练表示方法

预训练的方式学习表示通常需要大量的离线数据,且预训练学习到表示的迁移性对环境依赖性较强。因此,在相似环境中,通常需要对预训练表示在特定任务上微调。

另外,根据《Pretraining Representations for Data-Efficient Reinforcement Learning》,可知,足够好的表示应能够回答关于环境的如下问题:

- 若在状态$s$下采取动作$a$,那么下一个目标${s}'$是什么?

- 若从状态$s$转换到${s}'$,采取的动作$a$是什么?

- 若要最快的从状态$s$到${s}'$,采取哪个动作${a}'$?

这些问题均与奖励和任务无关,第一个属于前向动力学建模问题,第二个属于逆动力学建模问题,第三个属于以目标为条件的RL。为了学习到更好的表示,该论文结合了三个辅助损失函数,离线学习表示。

Augmented Temporal Contrast通过对相同轨迹中视觉观测时序对比的方式,预训练表示。在RL训练时,对编码器进行frozen,验证了该方式可提高样本效率。同时,也验证了多环境下训练的编码器的有效性。

Plus: 与学习环境动力学相比,学习提取视觉特征的表示的迁移性应该更强。

辅助损失

对于辅助损失,主要是在RL学习的过程中,增加相关损失,从而使网络能够有效的提取信息,以便于提高样本效率和策略性能的提升。《Loss is its own Reward: Self-Supervision for Reinforcement Learning》首次研究了预测奖励、动力学、逆动力学、以及重构的损失,对策略学习的影响。

对比表示

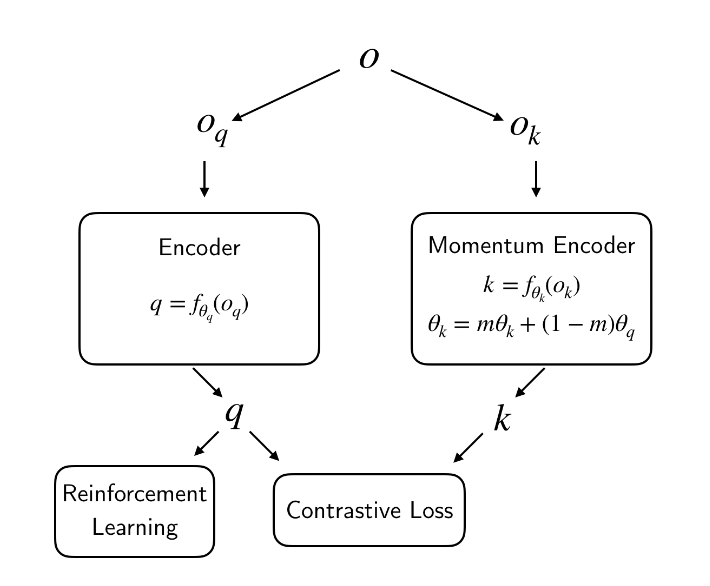

CURL利用对比损失对图片数据提取表示,同时利用off-policy算法学习控制机器人。如图1所示,CURL学习框架。

图1 CURL学习框架

Self-Predictive

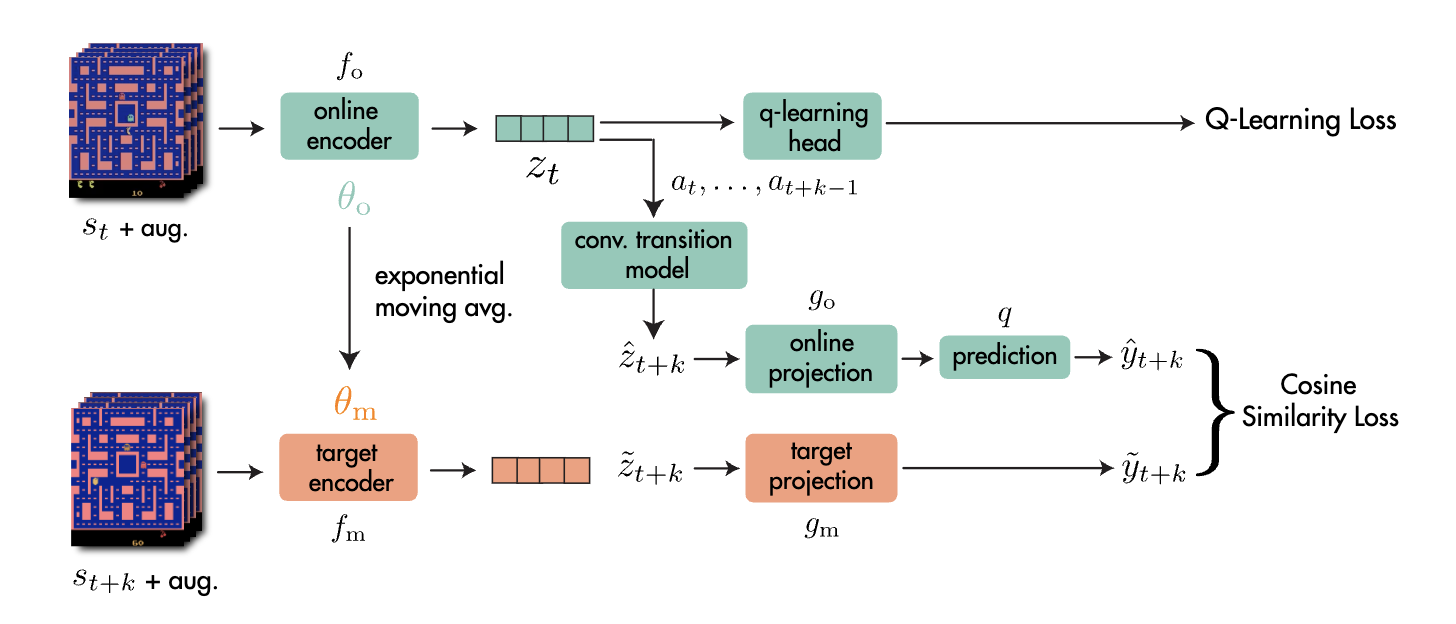

Self-Predictive Representations通过训练智能体学习预测未来多步隐式表示的方式,与端到端的智能体方式相比,提升了智能体的样本效率和性能。如图2所示,SPR学习框架。

图2 SPR学习框架

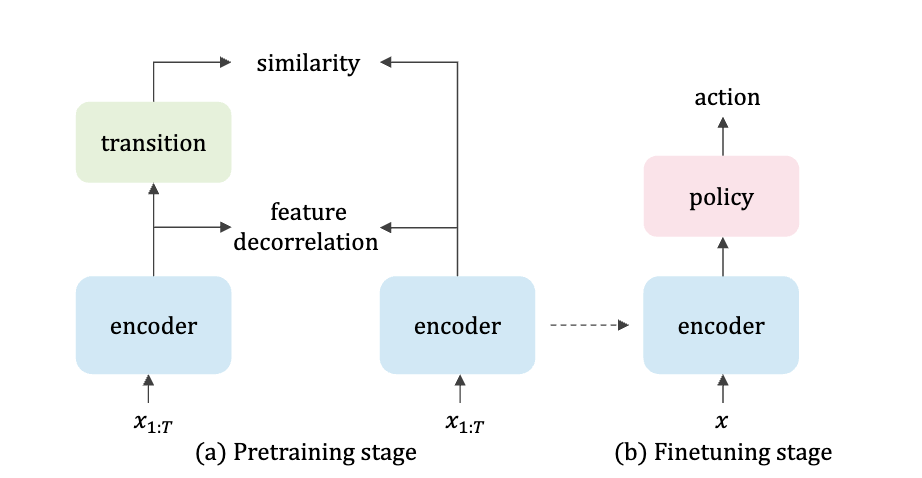

《On the Importance of Feature Decorrelation for Unsupervised Representation Learning in Reinforcement Learning》表示:预训练Self-Predictive表示的方式,容易出现表示坍塌。为了解决该问题,提出了在隐空间decorrelating特征,显著提升了样本效率。如图3所示,SimTPR学习框架。

图3 SimTPR学习框架

Bootstrapped表示

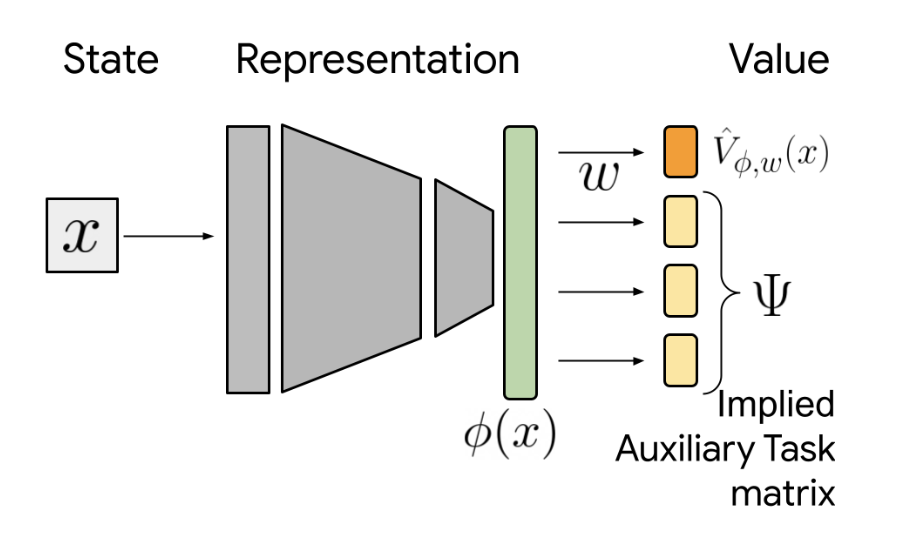

通过在价值函数学习网络架构增加辅助任务损失的方式,学习表示。如图4所示,Bootstrapped表示学习框架。

图4 Bootstrapped表示学习框架

Bootstrapped Representations in Reinforcement Learning研究了这种不同价值函数学习方法下表示的理论特性以及表示对策略评估的有效性。这种方式学习表示的任务有:控制观测状态视觉、预测多策略的价值、预测多个折扣因子的价值、预测下一个状态观测、以及奖励。

World Model

世界模型的方式就是建模环境的前向动力学和逆动力学。

One More Thing

这些表示提取方法的研究均是针对输入观测位视觉信息,且游戏环境。对于机器人仿真环境有效性,需要实践和思考去不断验证。

引用方法

请参考:

li,wanye. "RL中表示(二):表示的评估与提取方法". wyli'Blog (Jul 2025). https://www.robotech.ink/index.php/archives/747.html

或BibTex方式引用:

@online{eaiStar-747,

title={RL中表示(二):表示的评估与提取方法},

author={li,wanye},

year={2025},

month={Jul},

url="https://www.robotech.ink/index.php/archives/747.html"

}