深度持续学习的可塑性损失

深度学习网络基于随机梯度下降方法训练后,把网络权重冻结,再进行模型部署推理。然而,世界处于动态变化的,每天都有新的数据产生,从而导致数据分布发生变化。那么,若每次重新训练模型会产生很大的成本,而模型在新的数据上训练往往性能不如重新训练,这是因为学习过程中神经网络的可塑性降低。然而,深度学习在持续学习场景下有效性仍不清楚。Loss of plasticity in deep continual learning论文作者表明标准深度学习方法在持续学习环境中逐渐失去可塑性,直到其性能比浅层网络还要低。他们主要在ImageNet数据集和RL问题中研究了可塑性的损失,且提出了持续反向传播算法以提高算法的可塑性。

同时,作者们指出可塑性损失与灾难性遗忘不同,可塑性损失会关注表现不好的旧样本中知识,即使这些旧样本不在出现。

持续反向传播算法

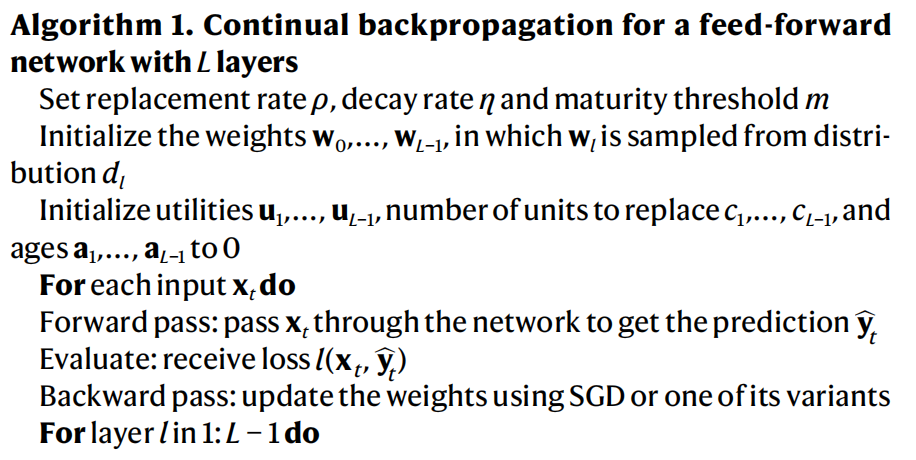

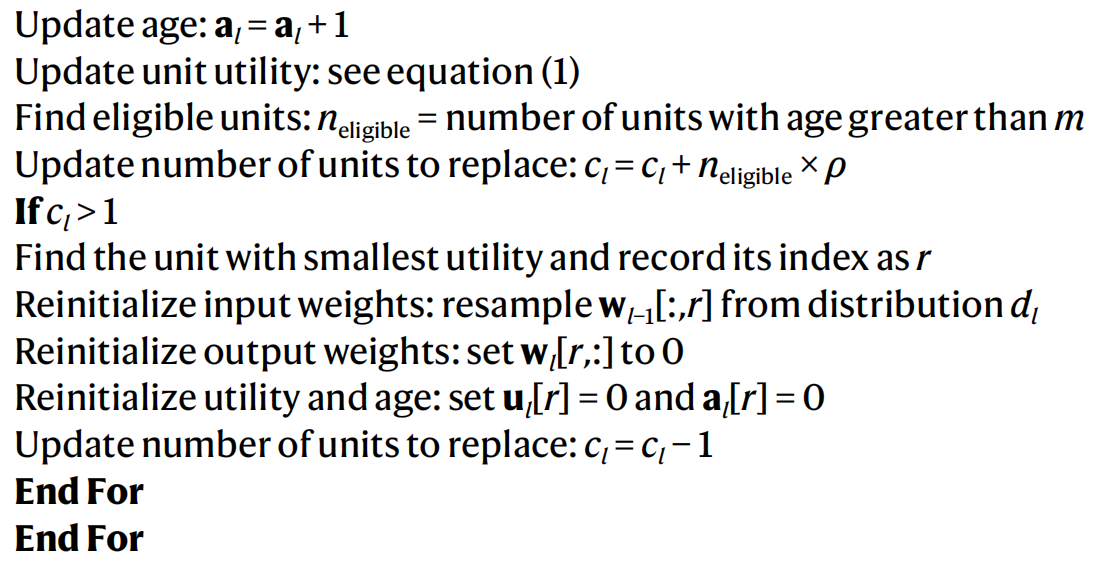

可塑性的维持需要持续的向网络中注入噪音。与经典的反向传播算法相比,持续性反向传播算法只有很小的差别,其主要在每步对很少被用的单元进行初始化。这种反向传播算法不仅有助于维持监督学习的可塑性,也可维持RL的可塑性,可见算法1。

确切的说,持续性反向传播选择性的重新初始化低效用单元。其中,效用测量被称为贡献效用,其背后的思想是单元激活与输出权重乘积的幅度表明了该连接的重要性。若一个隐藏单元的贡献较小,那么它的贡献会被其它的隐藏单元所覆盖,即该隐藏单元几乎无贡献。由此,作者们定义一个隐藏单元的贡献效用为其所有输出连接的效用和,可见式(1)

$$ \begin{aligned} \mathbf{u}_{l}[i]=\eta\times\mathbf{u}_{l}[i]+(1-\eta)\times\mathbf{h}_{l,i,t}\times\sum_{k=1}^{{n}_{l+1}}\vert\mathbf{w}_{l,i,k,t}\vert \end{aligned}\tag{1} $$

式(1)中$\eta$为即时贡献的衰退率,$\mathbf{u}_{l}[i]$为时刻$t$第层$l$的第$i$个隐藏单元,$\mathbf{h}_{l,i,t}$为时刻$t$第$l$层的第$i$个隐藏单元的输出,$\mathbf{w}_{l,i,k,t}$为该隐藏单元与第$l+1$层的第$k$个隐藏单元之间的权重,$n_{l+1}$为第$l+1$层神经元的个数。

持续反向传播算法的有效性表明深度神经网络的可塑性损失不是固有问题。

引用方法

请参考:

li,wanye. "深度持续学习的可塑性损失". wyli'Blog (Sep 2024). https://www.robotech.ink/index.php/archives/613.html

或BibTex方式引用:

@online{eaiStar-613,

title={深度持续学习的可塑性损失},

author={li,wanye},

year={2024},

month={Sep},

url="https://www.robotech.ink/index.php/archives/613.html"

}

CC版权: 本篇博文采用《CC 协议》,转载必须注明作者和本文链接

怎么收藏这篇文章?

可以通过收藏公众号对应文章的方式收藏,谢谢支持